“Est-ce que vos pages sont indexées ?”

C’est la question que je pose toujours tout de suite après qu’un client m’a dit : “les gens ne viennent pas sur mon site web”.

Beaucoup de gens pensent que mettre un site sur internet suffit pour qu’il soit indexé par les moteurs de recherche… ce qui n’est pas tout à fait vrai… mais pas tout à fait faux non plus.

En tout cas, avant de se voir tout en haut de la liste sur une requête sur Google, encore faut-il vérifier que vos pages y figurent… sur cette liste.

Dans cet article, nous allons procéder par étapes : après une courte explication sur le fonctionnement de l’indexation, je vous montrerais comment savoir si vos pages sont indexées grâce à de simples manipulations rapides.

Les bases de l’indexation : comment ça fonctionne

C’est simple : pour que votre site web soit indexé, il faut qu’un robot d’indexation (aussi nommé “crawler” (parcourir en anglais) ou “spider”) l’explore et le scan : on appelle ça un crawl (parcours en anglais).

Qu’est-ce qu’un robot d’indexation ?

Les robots d’indexation sont des petits programmes informatiques très sophistiqués qui circulent sur tout l’internet et ont 3 missions :

- explorer absolument tout l’internet,

- découvrir de nouveaux sites web ou explorer des sites web déjà indexés,

- extraire et stocker dans des serveurs les données essentielles d’un site web afin de les soumettre à un processus de qualification.

Les robots d’indexation fonctionnent page par page et plus précisément URL par URL.

Cela veut dire qu’ils vont aussi scanner les ressources différentes que vos pages HTML : les images, les documents (PDF, DOCS ou autres), les vidéos seront prises en compte durant l’exploration.

À moins qu’ils en soient empêchés (ce que nous verrons plus tard) il n’y a aucune limite à leurs explorations.

Enfin, les robots d’indexation exploreront aussi bien la version desktop d’un site web que sa version mobile, car, comme vous le savez, c’est la version mobile qui prime dans la façon de classer votre page sur les résultats de recherche.

Dessin officiel du Googlebot !

Comment fait un robot d’indexation pour trouver votre site web ?

Il trouve un lien externe qui pointe vers votre site web (un fameux backlink) et “emprunte” cette route pour trouver votre site web.

Vous pouvez aussi l’inviter à venir vous voir grâce à des outils essentiels au SEO comme la Google Search Consol ou son équivalent chez Microsoft : Bing Webmaster Tools (aussi utiliser pour Yahoo!).

Je reviendrai plus tard sur ces outils absolument géniaux !

Que se passe-t-il après que votre site web ait été crawlé ?

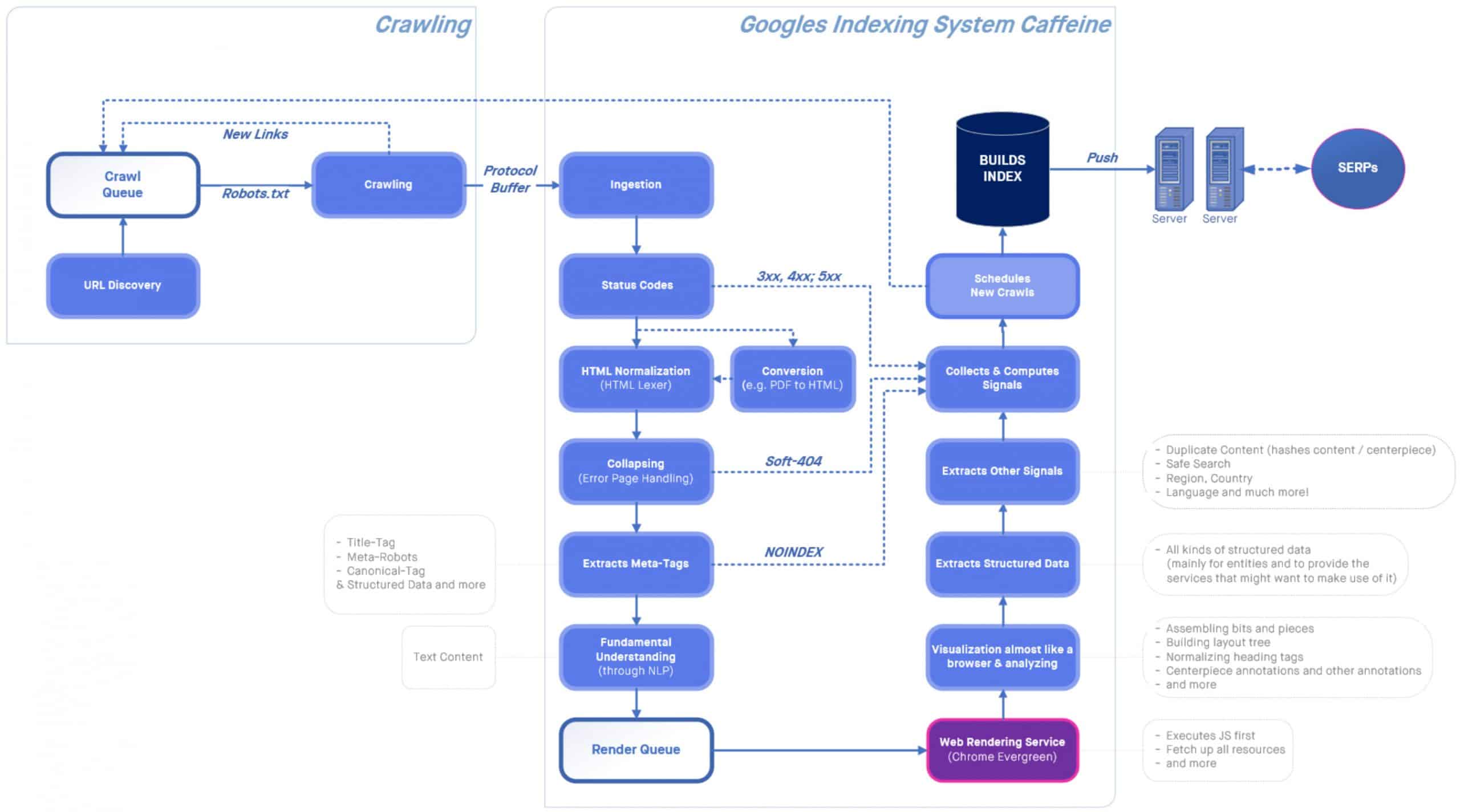

Le contenu que le robot d’indexation a scanné passe par des étapes très complexes et… assez mystérieuses. C’est ici que les fameux algorithmes (ceux de Google portent même un nom comme Panda ou Penguin) entre en action pour analyser le contenu de votre site web et juger de sa qualité SEO. Au bout d’un fastidieux processus composé de nombreuses phases d’analyse, le résultat arrive : votre page (ou plus précisément votre URL) apparait sur les index… ou pas !

Ci-dessous, le fastidieux processus qui permet une indexation d’une page sur Google (et encore là, c’est la version simplifiée !!! Source Twitter).

Vérifier que vos pages sont bien indexées

Taper tout simplement le nom de votre page dans un moteur de recherche. S’il vous trouve, c’est qu’il a indexé votre page… et voilà, c’est fini, vous pouvez retourner à vos occupations quotidiennes…

Mais non bien sûr, ce n’est pas aussi évident !

Faire une simple recherche Google ne suffit pas pour vérifier votre indexation

Déjà, il faut savoir que quand vous faites des recherches sur Google, vous ne faites pas de recherche sur tout l’internet, mais sur l’index de Google. Donc dans le cas où votre page ne serait pas présente pas sur cet index… bah, c’est foutu.

De plus, avec cette méthode, vous risquez de ne pas trouver votre page et d’en conclure que vous n’êtes pas indexé. Il faut se rappeler que quand vous taper quelque chose dans le champ du formulaire de votre moteur de recherche préféré, il s’agit d’une requête et non d’une instruction. Elle va passer par un certain nombre de mécanismes et la réponse sera celle qui, selon le moteur en question, sera de la meilleure qualité. Ainsi si vous ne trouvez pas votre page par cette méthode, c’est que le moteur aura simplement conclut que d’autres réponses sont plus pertinentes que la vôtre.

Le petit truc à connaitre pour savoir sir vos pages sont classées sur l’index Google

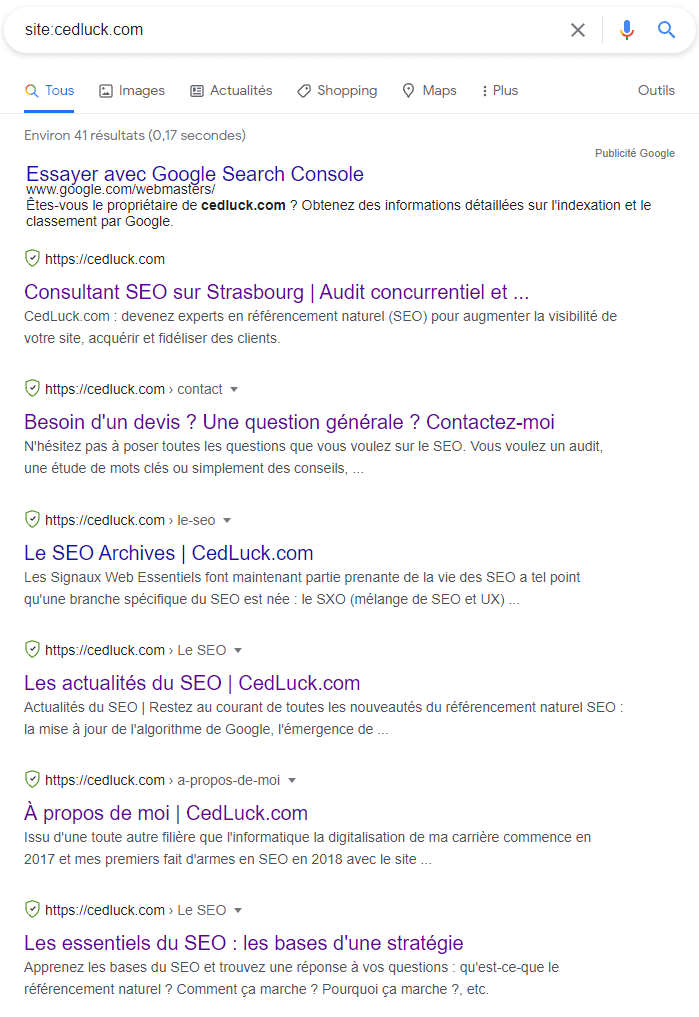

Pour être sûr de voir si votre page est indexé ou pas, il y a un petit truc que les experts SEO utilise tout le temps : tapez la commande “site:” puis taper l’adresse de votre site web. Par exemple, tapez “site:monsite.fr”. Attention de bien faire exactement comme indiquer, c’est-à-dire de ne pas mettre d’espace en avant et après le double point (je sais, c’est dur de ne pas respecter les codes de la typographie, mais c’est pour la bonne cause).

Vous obtiendrez une page de réponse avec toutes les pages de votre site web que le moteur de recherche a indexé… ou presque, cela dépend du nombre de pages. À noter que la réponse n’est pas toujours fiable, car la commande ne contient pas de mots-clés, mais c’est un bon moyen de voir si une page est présente dans l’immense index de Google (plus de 40 milliards de pages).

Vous trouvez votre page sur les résultats de recherche ? Tout va bien, la page est indexée. Le problème maintenant, c’est de classer vos pages, le plus haut possible dans l’index du moteur de recherche, mais c’est une autre histoire.

Le problème est de savoir ce qui ne va pas si vous constatez que votre page n’apparait pas : il faut alors vérifier les points suivants.

Les 3 fichiers

“Trois fichiers pour les gouverner tous, pour les trouver, pour les amener tous et dans les ténèbres les lier” dirait un équivalent SEO de Gandalf le Gris, car ce sont trois fichiers qui peuvent avoir un impact décisif sur la présence ou non d’une page sur les SERP (Search Engine Respons Pages).

Le fichier .htaccess

Le premier, .htaccess, ne concerne pas seulement le référencement, mais peut empêcher une page ou tout un site web d’être crawlé. Ce fichier contrôle en effet qui peut avoir accès au site web. Mal utilisé, il empêche tout simplement une page d’être accessible en renvoyant une réponse HTTP de type 3XX, 4XX ou 5XX. Dans ce cas, la page devient tout simplement invisible (demander à l’équivalent SEO de Frodon le Hobbit pour voir ce que ça fait !). Attention alors à ne pas manipuler ce fichier sans de solides connaissances. Demandez à un expert de le faire pour vous si vous n’y connaissez rien.

Le fichier robots.txt

Le deuxième est spécifiquement destiné aux robots d’indexation… d’où son nom : ROBOTS.txt. Il sert à dire au robot d’indexation “oui tu peux crawler tel page (URL)” ou “ non, ne crawl pas cette page (URL)”.

Là aussi une certaine maitrise du sujet et surtout une grande rigueur permet d’éviter l’écueil d’une non-indexation. Les lumières d’un expert vous aideront à y voir plus clair (une sorte d’équivalent SEO de Galadriel).

Le fichier sitemap.xml

Le troisième, sitemap.xml, est un peu différent dans le sens où il n’empêche pas vraiment les pages de votre site web d’être crawlé ou indexé. Un sitemap permet au moteur de recherche de donner une image précise de la structure de votre site web. C’est un énorme avantage pour faire indexer vos pages, car non seulement toutes les pages du site web seront facilement trouvées, mais les robots vont mieux utiliser leur budget de crawl. Ah oui, il faut que je vous parle de ça : les robots ont un nombre de ressources limitées de crawl qu’on appelle le budget de crawl. Lorsque ce potentiel est épuisé, le robot arrête de crawler. S’il reste des pages à visiter, celles-ci ne le seront pas, et donc elles ne seront pas indexées. Un sitemap permet au robot d’optimiser son budget de crawl et d’être (presque) certain que toutes les pages sont bien explorées. (Je n’ai pas d’équivalent SEO d’un personnage Tolkiennien pour illustrer mon propos sur ce coup-là !)

Les balises meta

Les balises qui se trouvent dans la partie haute du code de votre page, qu’on appelle communément “balise meta” (pour métadonnée) influencent aussi l’indexation de vos pages. Si elles sont mal écrites, elles peuvent avoir un effet néfaste sur l’indexation.

La balise meta robots.

Elle ressemble à peu près à ça :

<meta name= »robots » content= »index, follow » />

Elle sert à demander au robot d’indexer ou de ne pas indexer la page. En effet, une page peut être crawlée, mais pas indexée. Ici elle lui permet aussi de suivre les liens présents sur la page grâce à la valeur “follow” de l’attribut “content”.

Un certain nombre de valeurs peuvent être ajoutées à cet attribut (séparer par une virgule). Elles permettent un contrôle plus précis de l’indexation de tous les éléments de votre page. Faites appel à un expert pour les intégrer dans vos pages, vous en retirerez un avantage certain.

La balise <title>

Présente dans l’en-tête de votre code, c’est LA balise SEO par excellence. Son absence ou une erreur dans son écriture l’empêche d’être active et ralentit considérablement l’indexation de votre page. Cette balise permet de matcher avec les requêtes que vous voulez toucher, et bien sûr les internautes qui tapent ces requêtes.(l’équivalent SEO de l’anneau unique lui-même !)

D’autres balises de métadonnées permettent d’améliorer l’indexation de votre site web dans une moindre importance et surtout dans des cas particuliers : le cas d’un site web internationalisé (balise hreflang), dans le cas d’un blog (balise meta author), le cas d’un site catalogue/e-commerce avec beaucoup de contenu dupliqué (balise canonique, balise de pagination) et bien d’autres…

Les outils d’indexation : le moyen le plus sûr d’indexer vos pages

Alors vous pouvez très bien faire des recherches pages par pages sur votre site web en essayant de regarder le code ou la présence des éléments que j’ai évoquée ci-dessus, mais il y a un moyen assez facile de savoir si les moteurs de recherche daignent bien indexer vos pages : il suffit de le leur demander.

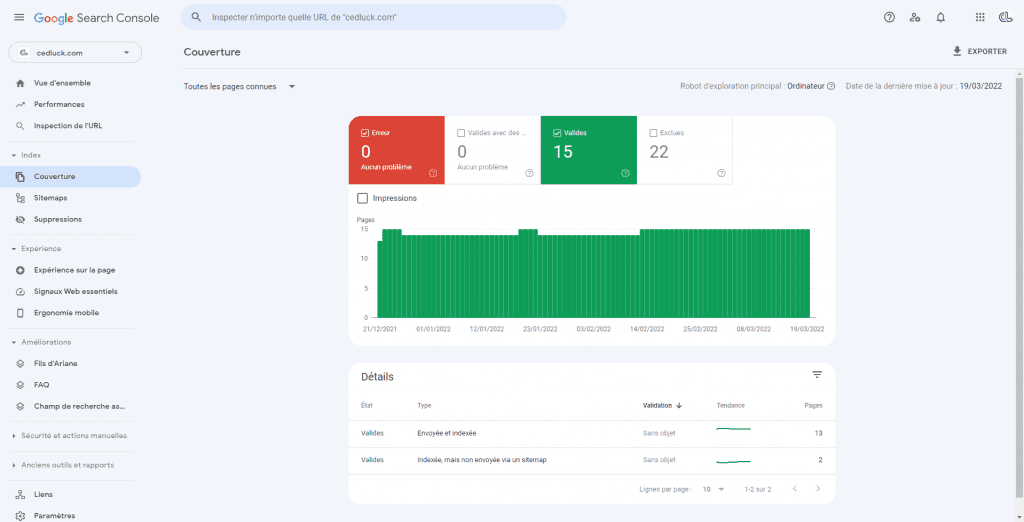

C’est pour cela que les moteurs de recherche mettent à votre disposition des outils en ligne entièrement dévouer au contrôle de votre indexation : Google Search Control et Bing Webmaster Tools.

Non seulement ces outils vous permettront de savoir quelle page est indexée ou pas, mais aussi pourquoi. Ils vous permettront aussi de soumettre une nouvelle page à l’indexation (il faudra toutefois attendre qu’un robot explore votre page). L’avantage de cette méthode de soumission est que l’outil fera un diagnostic préalable de votre page et vous indiquera si elle est indexable ou pas.

Pour les activer il suffit de rajouter un petit code dans l’en-tête de vos pages. Comme vous vous en doutez un expert saura vous faire ça sans problème. Je ne vais pas m’étendre sur les nombreuses fonctionnalités qui permettent une analyse précise de l’impact SEO de votre site web, car cela fera l’objet d’un autre article (encore plus long que celui-ci).

Pour résumer cet article :

- Vos pages sont indexées par les moteurs de recherche grâce au passage d’un robot d’indexation

- Les robots d’indexation trouvent vos pages grâce à des liens entrants ou grâce à votre soumission de la page dans les outils d’indexation.

- Les robots disposent d’un budget de crawl qui baisse au fur et à mesure qu’il visite vos pages, jusqu’à son épuisement. Il est donc opportun de l’optimiser.

- Pour savoir à peu près quelque page est indexé sur les moteurs de recherche, tapez”site:nondemonsite.com”

- 3 fichiers peuvent empêcher ou influencer le crawl de vos pages : .htaccess, robots.txt, sitemap.xml; consultez un expert pour les maitriser.

- Des balises dans l’en-tête du code de vos pages peuvent influencer sur leur présence sur les résultats de recherche, notamment la balise “meta robots”.

- Pour voir si vous êtes ou non indexé, deux outils extraordinaires sont à votre disposition : Google Search Control et Bing Webmaster Tools. Vous pouvez même demander l’indexation de vos pages.

Enfin je terminerai par faire 2 remarques :

Si vous n’êtes pas indexé, c’est peut-être tout simplement que votre site web ne l’est pas encore. Le robot est probablement déjà passé, mais les moteurs de recherche analysant des milliards de pages (+40 milliards pour Google et +14 pour Bing) il faut parfois patienter avant de se voir classer dans les résultats de recherche. Surtout dans l’éventualité où votre site web est récent et pas encore totalement optimisé en SEO.

Pour voir quand un robot d’indexation est passé sur votre site web, trouver votre page dans Google et appuyez sur la petite flèche (qui pointe vers le bas) à côté du titre de votre page : une infobulle s’ouvre avec la mention “En cache” : cliquez dessus et vous aurez la “rendition” (rendering en anglais) de votre page lors du dernier passage du robot. De plus, un bandeau en haut de la page vous indiquera la date et l’heure du dernier passage d’un robot. Cette page rendue est l’interprétation de votre page tel que les algorithmes la voie, c’est-à-dire en interprétant tous les codes qui y sont associés (JavaScript et CSS notamment). Essayer de déterminer l’intervalle de temps que mettra une page à être visité par les robots. Cela vous donnera aussi un aperçu de la notoriété de cette page.